AI Act, la scadenza si avvicina: come cambia il lavoro nelle aziende

Sommario

Il conto alla rovescia è iniziato: nel 2026 il regolamento europeo sull’Intelligenza Artificiale (AI Act) sarà pienamente applicabile, e per molte aziende il tempo per adeguarsi sta per scadere. Chi non si conforma rischia pesanti sanzioni fino al 7% del fatturato.

Introdotto dal Regolamento (UE) 2024/1689, l’AI Act è il primo tentativo al mondo di regolamentare in modo sistematico lo sviluppo e l’uso dell’intelligenza artificiale. Approvato nel 2024, introduce obblighi crescenti basati sul livello di rischio dei sistemi, ridefinendo il rapporto tra tecnologia, governance e responsabilità aziendale.

Dal credito alle risorse umane, dalla sanità al marketing, ogni settore è potenzialmente coinvolto. Le imprese dovranno garantire trasparenza, sicurezza, tracciabilità e controllo umano, pena blocchi operativi e sanzioni.

La grande scadenza per tutti: agosto 2026

Il percorso di attuazione dell’AI Act è stato pensato in modo graduale, ma le scadenze sono già scritte nero su bianco.

- Agosto 2024. Dopo l’entrata in vigore formale, l’Unione Europea ha previsto un’applicazione scaglionata delle norme per dare tempo alle imprese di adeguarsi. I primi divieti su sistemi di AI ritenuti “inaccettabili” – come la manipolazione comportamentale o la classificazione biometrica su base etnica – sono già attivi.

- Febbraio 2025. Sono entrati in vigore gli obblighi per i modelli di intelligenza artificiale generativa (foundation models)

- Agosto 2025. Scattano i primi adempimenti per i sistemi ad alto rischio.

- Agosto 2026. La vera deadline: da quel momento, tutte le disposizioni dell’AI Act diventeranno pienamente applicabili. Chi sviluppa o utilizza sistemi di intelligenza artificiale nei propri processi dovrà essere conforme a tutti gli obblighi previsti, pena sanzioni fino a 35 milioni di euro o al 7% del fatturato annuo globale.

Cosa prevede l’AI Act

Le nuove norme sull’IA ridefiniscono processi, ruoli e responsabilità, portando la gestione dell’Intelligenza Artificiale dentro la governance aziendale.

L’EU AI Act introduce un sistema di regole comuni che mira a garantire sicurezza, trasparenza e tutela dei diritti fondamentali, stabilendo per la prima volta un quadro normativo unitario per l’uso dell’AI nei Paesi membri.

Quali sono gli obiettivi dell’AI Act emerge dal principio che lega l’intera normativa: garantire che i rischi legati all’uso dell’Intelligenza Artificiale siano valutati e gestiti in modo proporzionato, senza ostacolare l’innovazione.

Per raggiungere questo scopo, l’AI Act EU si fonda su un approccio basato sul rischio, distinguendo tra sistemi di Intelligenza Artificiale a rischio minimo, limitato, alto o inaccettabile. Questa classificazione determina gli obblighi di conformità per sviluppatori e utilizzatori.

AI Act: applicazioni a rischio inaccettabile

Le applicazioni considerate a rischio inaccettabile, come la manipolazione comportamentale o i sistemi biometrici che classificano le persone sulla base dell’etnia o di orientamenti politici e religiosi, sono vietate nell’Unione Europea.

AI Act: sistemi a rischio elevato

I sistemi a rischio elevato – tipici in settori come la finanza, la sanità o le risorse umane – devono rispettare requisiti rigorosi: documentazione tecnica, informazione agli utenti, supervisione umana, robustezza, sicurezza e precisione.

Le imprese che sviluppano o utilizzano algoritmi di scoring del credito, selezione automatica del personale o diagnostica medica devono effettuare una valutazione del rischio e stabilire un sistema di gestione della qualità, oltre a rispettare obblighi di registrazione, tracciabilità e segnalazione. La conformità è verificata da organismi indipendenti incaricati di rilasciare certificati.

AI Act: sistemi a rischio limitato o minimo

Diversamente, gli obblighi si alleggeriscono per i sistemi di IA classificati a rischio limitato e, ancor di più, a rischio minimo o nullo.

I sistemi a rischio limitato sono soggetti a obblighi di trasparenza – comunicazione dell’interazione con l’IA e fornitura di informazioni chiare su caratteristiche e limitazioni – per consentire agli utenti una scelta consapevole.

I sistemi a rischio minimo o nullo non hanno obblighi specifici sull’IA, ma restano soggetti alle normative generali su protezione dei dati, concorrenza e tutela dei consumatori.

Chat GPT, Claude e Gemini: anche loro nel mirino?

Tra le novità più rilevanti introdotte dall’AI Act c’è l’inquadramento giuridico dei foundation models, i modelli di intelligenza artificiale generativa come ChatGPT, Claude o Gemini, capaci di produrre testi, immagini, codice e altri contenuti a partire da semplici input.

Questi modelli, spesso sviluppati da grandi attori globali, sono soggetti a obblighi specifici di trasparenza, documentazione tecnica, protezione dei diritti d’autore e segnalazione dei contenuti generati (es. watermarking).

I foundation models classificati come “sistemi ad alto impatto” – in grado di influenzare significativamente mercati, sicurezza o processi democratici – dovranno inoltre rispettare requisiti aggiuntivi di robustezza, sicurezza e governance del rischio.

Le aziende europee che integrano questi modelli nei propri prodotti o servizi dovranno accertarsi che i fornitori siano conformi e potrebbero essere chiamate a implementare misure di controllo, audit e monitoraggio anche a valle dell’adozione.

Chi è coinvolto e come cambiano i ruoli in azienda

L’Artificial Intelligence Act riguarda un’ampia platea di soggetti. Sono coinvolti non solo i fornitori che sviluppano o mettono sul mercato sistemi di Intelligenza Artificiale, ma anche gli utilizzatori che li impiegano nei propri processi interni. La distinzione è importante, perché da essa dipendono obblighi diversi.

I fornitori devono garantire la qualità dei dati di addestramento, la sicurezza dei sistemi e la tracciabilità delle decisioni automatiche. Gli utilizzatori, invece, sono responsabili del modo in cui l’IA viene impiegata. Devono informare gli utenti, monitorare il funzionamento del sistema e segnalare eventuali rischi o malfunzionamenti.

Per le aziende, ciò comporta l’introduzione di nuove figure professionali e funzioni dedicate alla gestione dell’Intelligenza Artificiale. Si diffonderanno ruoli come l’AI compliance officer, incaricato di supervisionare la conformità normativa, e il data governance manager, responsabile della qualità e della tracciabilità dei dati.

In molte organizzazioni nasceranno comitati interdisciplinari dedicati all’AI governance, con competenze legali, tecniche ed etiche.

Questa evoluzione non riguarda solo i grandi gruppi: anche le PMI che adottano soluzioni basate sull’AI dovranno dotarsi di strumenti di controllo e di procedure interne per gestire i rischi. La sfida sarà integrare questi nuovi adempimenti senza rallentare l’innovazione.

Come cambiano i processi aziendali con l’AI Act

L’applicazione graduale dell’Artificial Intelligence Act richiede alle imprese di rivedere i propri flussi operativi.

I dipartimenti IT e Data Management devono garantire la tracciabilità dei dataset e documentare le fasi di sviluppo e implementazione dei sistemi di AI. Le funzioni Compliance e Legal saranno chiamate a integrare nei modelli organizzativi i nuovi obblighi di valutazione, controllo e reporting.

Le aree HR dovranno verificare che gli strumenti di Intelligenza Artificiale impiegati nei processi di selezione o valutazione del personale non producano discriminazioni.

I reparti Marketing e Customer Service, quando utilizzano chatbot o sistemi automatizzati, dovranno informare chiaramente gli utenti sull’interazione con l’AI.

In molte imprese diventerà necessario un sistema di gestione integrata dell’Intelligenza Artificiale, che unisca le logiche di privacy, sicurezza informatica e qualità dei dati. L’AI non sarà più una tecnologia da adottare caso per caso, ma un ambito regolato da procedure e responsabilità definite.

Le sfide per le imprese

L’entrata in vigore dell’Artificial Intelligence Act rappresenta per le aziende una transizione complessa. L’adeguamento richiede risorse economiche, tempo e competenze specifiche. Le imprese devono aggiornare policy interne, formare il personale e stabilire relazioni con organismi di valutazione e certificazione.

Molte realtà, in particolare le PMI, stanno cercando di capire come gestire la mole di adempimenti previsti per i sistemi a rischio elevato.

La sfida non è solo rispettare la legge, ma mantenere nel tempo la conformità.

Ogni aggiornamento di un sistema AI o variazione dei dati di addestramento può modificare il livello di rischio e richiedere una nuova valutazione. Per questo la gestione dell’Intelligenza Artificiale dovrà diventare parte integrante dei processi aziendali, con controlli costanti e responsabilità distribuite.

I 5 passi fondamentali per l’adeguamento all’AI Act

Per affrontare questa transizione in modo strutturato, le aziende possono partire da cinque azioni concrete:

- mappare i sistemi di Intelligenza Artificiale utilizzati o in fase di sviluppo, valutando finalità, provenienza dei dati e livello di rischio;

- istituire un sistema di gestione interno, che definisca ruoli, responsabilità e procedure di verifica;

- documentare le attività di sviluppo e utilizzo dell’AI, conservando evidenze utili in caso di controlli;

- formare il personale sui principi del regolamento e sui rischi connessi all’uso dell’Intelligenza Artificiale;

- collaborare con consulenti tecnici e legali per garantire un approccio coerente con le previsioni dell’EU AI Act.

L’adeguamento non si esaurirà in un’unica fase. L’applicazione graduale della normativa impone alle imprese di mantenere un presidio costante, aggiornando processi e strumenti in linea con l’evoluzione delle linee guida europee.

Il rispetto dell’Artificial Intelligence Act diventerà così un elemento strutturale della gestione aziendale, al pari della sicurezza o della protezione dei dati personali.

Infografica

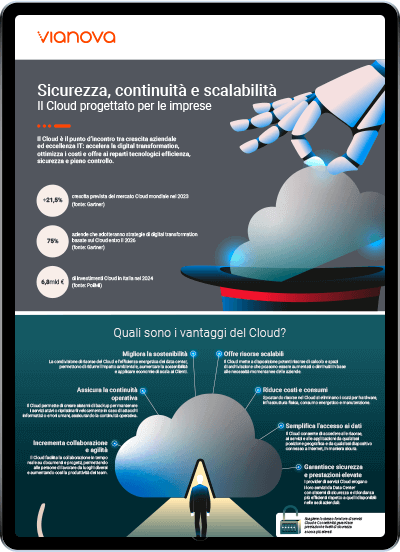

Sicurezza, continuità e scalabilità

Per scaricare questo contenuto e ricevere altre notizie sul mondo TLC iscriviti alla nostra Newsletter